Aclarando dudas sobre robots.txt y la indexación de páginas en Google

El video con que iniciamos este post es otro de la serie de excelentes videos publicados por Matt Cutts, en el que habla de un tema sobre el que varios tienen aún muchas dudas: el correcto uso del archivo robots.txt y cómo afecta este a la manera en que Google indexa una página.

Tal y como ya había explicado en un artículo anterior al respecto en este blog (“El archivo robots.txt y la meta etiqueta Robots”), el archivo Robots.txt nos permite indicarle a Google que páginas o secciones de nuestra web no debe rastrear; es decir, sus contenidos no deben ser almacenados en la base de datos de Google. Lamentablemente, y con esto inicia Matt Cutts el video, existen muchas personas que se quejan porque, por ejemplo, en su archivo robots.txt colocaron el comando “Disallow: /midirectorio/” y, sin embargo, ven que en los resultados de Google aparece “miweb.com/directorio/ejemplo.html“.

Pues bien, estas quejas parten de una equivocada comprensión de la funcionalidad de dicho archivo y el comando “disallow“, ya que si bien es cierto Google no indexa el contenido de la página /midirectorio/, si por algún motivo existen enlaces entrantes hacia esa página, efectivamente Google no mostrará el contenido de la misma ya que este nunca fue almacenado en su base de datos, pero si mostrará una referencia a la misma en sus resultados de búsqueda si considera que esta página tiene cierto valor (determinado por la cantidad y cantidad de enlaces hacia la misma). Es más, si dicha página se encuentra inscrita en el Open Directory Project (directorio popularmente conocido como DMOZ), Google puede tomar dicha descripción para mostrarla en sus resultados, por lo que a primera vista parecerá un error el ver una URL junto con una descripción para una página que supuestamente hemos bloqueado mediante robots.txt.

Pero, ¿cuál es el sentido de mostrar en los resultados de búsqueda una página cuyo contenido el autor no quiere que sea indexado? Matt Cutts lo explica mediante un caso práctico. En una ocasión, el Departamento de Vehículos a Motor de California (www.dmv.ca.gov) bloquó el acceso de todos los motores de búsqueda a su página mediante robots.txt. Pero, si alguien ingresa a Google y tipea “California DMV”, es 99% seguro que lo que están buscando es ingresar a dicha web. Además, si bien es cierto la página estaba bloqueada mediante robots.txt, existe un montón de gente enlazando a la misma, varios con el texto “California DMV” como anchor text . Dado que la política de Google es brindar a sus usuarios los mejores resultados para cualquier búsqueda, es lógico mostrar dicha página como resultado, aunque sin mostrar partes de su contenido tal y como lo establece el archivo robots.txt.

Pues bien, ¿que sucede si definitivamente no deseo que mi página o parte de ella se muestre en los resultados de búsqueda de Google?. En este caso, puedes utilizar la meta etiqueta robots con el operador “noindex“. Esta etiqueta va en algun lugar entre el <head> y </head> en la página que quieres bloquear, y luce de la siguiente forma:

<meta name="robots" content="noindex">

Si aplicamos esta etiqueta a una página, luego esta definitivamente nunca se mostrará en los resultados de búsqueda de Google PERO esto no implica que no pueda acumular PR y traspasarlo a las páginas a las que enlaza. Si no deseamos que esta página traspase el PR que tiene acumulado hacia otras páginas (lo cual no tiene sentido en realidad, si acumula PR es mejor traspasarlo), debemos agregar el operador “nofollow” a la meta etiqueta robots, la cual quedaría de esta forma:

<meta name="robots" content="noindex, nofollow">

IMPORTANTE: Antes de aplicar la meta etiqueta robots con el valor “noindex” a una página, debemos asegurarnos de no bloquearla vía robots.txt, ya que esto evitará que el bot de Google lea el código de la misma y, por ende, la meta etiqueta.

El problema con el uso de la meta etiqueta robots es que esta se debe copiar a cada página que deseamos bloquear, lo cual hace la tarea un poco más trabajosa. Esto se puede resolver recurriendo a la herramienta “URL Removal Tool” en las herramientas para webmasters de Google (Leer: Registrando nuestros blogs con las herramientas para webmasters de Google).

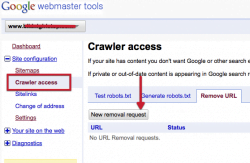

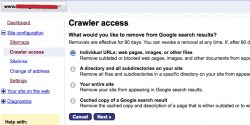

Luego registrar nuestra página y acceder a las herramientas para webmasters, nos dirigimos a “Crawlers access -> Remove URL -> New removal request“. Desde aquí podremos eliminar del índice de Google páginas individuales de nuestro sitio (buenas opciones son eliminar las páginas de Login y el mapa del Sitio, por ejemplo), directorios o subdirectorios de nuestra web, nuestra página completa o una copia en cache de Google del título y descripción de una página de nuestro sitio.

Estoy seguro que el post y video de hoy les va a aclarar las cosas a muchos. Si añun así tienen dudas o consultas sobre el tema, no duden en dejarlas en los comentarios.